Jak to możliwe, że na jednej półce z książkami z dziedziny zarządzania pojawiają się pozycje takie jak „Zarządzaj jak papież Franciszek” i „Tresuj swoich niewolników”? Oba tytuły są oczywiście fikcyjne. Skoro podejścia do zarządzania są tak różne i ewidentnie sprzeczne – które przyniesie najlepsze rezultaty?

Jak to możliwe, że na jednej półce z książkami z dziedziny zarządzania pojawiają się pozycje takie jak „Zarządzaj jak papież Franciszek” i „Tresuj swoich niewolników”? Oba tytuły są oczywiście fikcyjne. Skoro podejścia do zarządzania są tak różne i ewidentnie sprzeczne – które przyniesie najlepsze rezultaty?

Czy zarządzanie, podobnie jak wiele innych dziedzin życia jest kształtowane przez trendy i mody, które nie mają nic wspólnego ze skutecznością promowanych praktyk? Jeśli tak – jak odróżnić praktyki, których wdrożenie przyniesie nam korzyści od tych, które są jedynie „chwytem marketingowym”?

Zarządzanie oparte na dowodach

„W Bogu pokładamy wiarę, wszyscy inni muszą przedstawiać dane.” Edward Deming.

Na zadane w poprzedniej części pytanie o skuteczność praktyk można znaleźć odpowiedź zarządzając w oparciu o dowody. Praktyki oparte na dowodach polegają na: „podejmowaniu decyzji poprzez świadome, jawne i rozważne użycie najlepszych dowodów z wielu źródeł (…) dla zwiększenia prawdopodobieństwa uzyskania oczekiwanego rezultatu”. Jedna z popularyzatorek tego nurtu, wymienia cztery istotne kierunki działania2:

- Wykorzystanie najlepszych dostępnych dowodów naukowych;

- Gromadzenie i wykorzystywanie faktów, wskaźników i miar płynących z organizacji w sposób usystematyzowany, tak, by zwiększyć ich rzetelność i użyteczność;

- Stałe wykorzystanie krytycznego, refleksyjnego osądu i metod pomagających w podejmowaniu decyzji w celu ograniczenia błędów poznawczych i uzyskania lepszej jakości decyzji;

- Uwzględnianie kwestii etycznych – krótko i długoterminowego wpływu decyzji na interesariuszy.

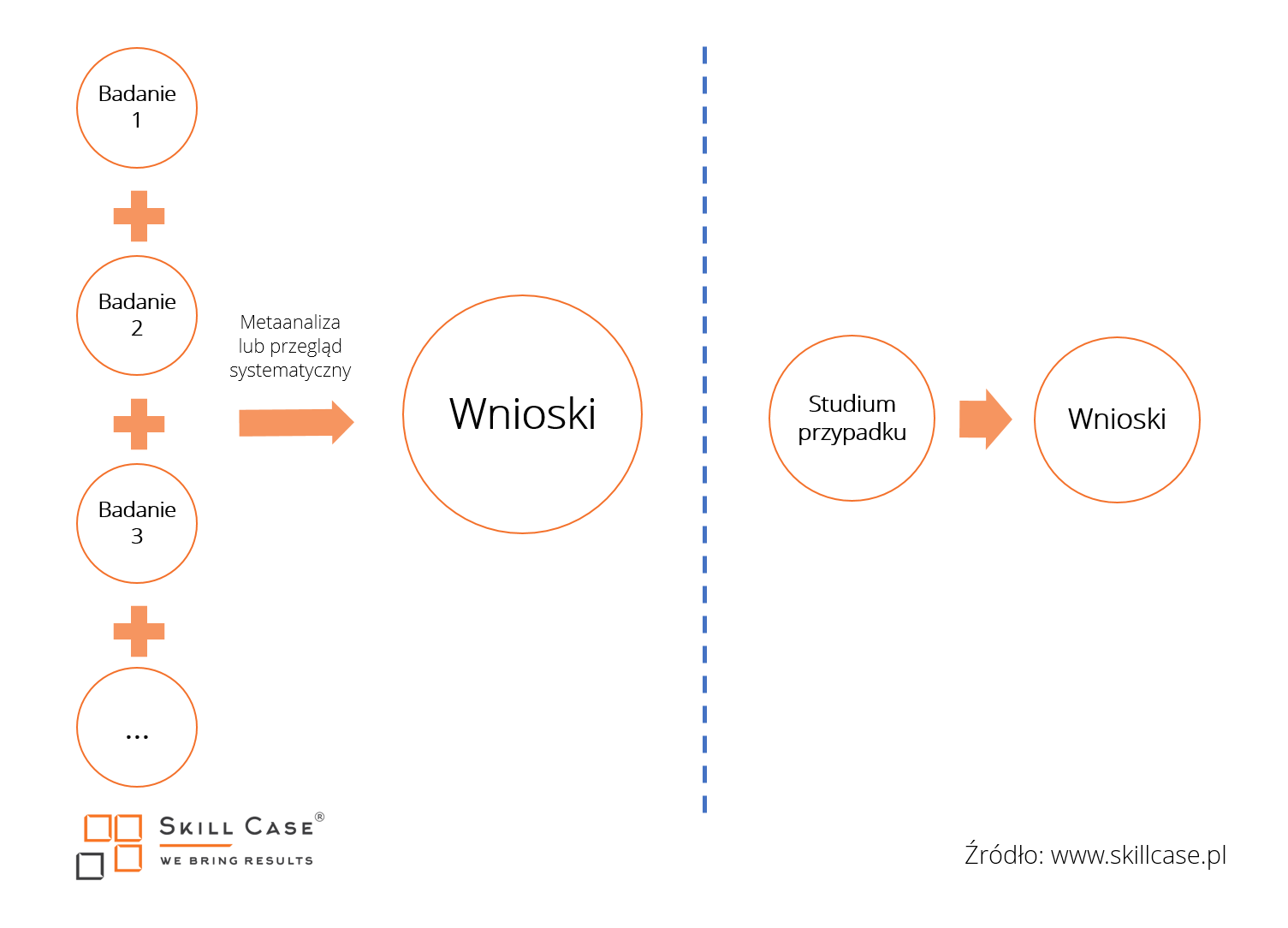

Najlepsze dostępne dowody

W języku potocznym dowód utożsamiany jest z taką informacją, która ponad wszelką wątpliwość uzasadnia dane stwierdzenie. W rzeczywistości dowody mają różną wiarygodność, te bezsprzeczne można przedstawić jedynie w matematyce. Wiarygodność, czy też siłę dowodu możemy określić jako prawdopodobieństwo z jakim informacja faktycznie świadczy o istnieniu określonego zjawiska. Siłę dowodu można oprzeć na dwóch kryteriach – liczbie zbadanych przypadków (tzw. „próbie” – im większej tym lepiej) i liczbie czynników, które mogły sprawić, że „dowód” powstał w wyniku błędnego wyciągnięcia wniosków (im mniej – tym lepiej). Zestawmy dwie skrajne kategorie dowodów – metaanalizę badań i studium przypadku. Metaanaliza (lub szerzej – przegląd systematyczny) polega na zebraniu w uporządkowany sposób danych z licznych badań i porównaniu ich w systematyczny sposób (w przypadku metaanalizy sprowadzając wyniki do tej samej skali, uwzględniając błędy pomiaru itd.). Studium przypadku natomiast skupia się na pojedynczej organizacji/praktyce, na podstawie której wyciągane są zgeneralizowane wnioski dotyczące skutecznych działań.

Metaanaliza a studium przypadku

Studia przypadków obarczone są pokaźną liczbą czynników, które sprawiają, że wyciągane na ich podstawie wnioski są niepewne. Różnice pomiędzy organizacjami takie, jak: kultura, branża, otoczenie biznesowe, kompetencje pracowników i inne, mogą spowodować, że działania opisane w studium przypadku jako skuteczne w jednych firmach, w innych nie przyniosą pożądanych efektów lub nawet będą szkodliwe. Używając obrazowego porównania – to, że nasza sąsiadka paliła papierosy przez większą część życia, a aktualnie ma 92 lata i jest okazem zdrowia (jak na swój wiek, oczywiście) nie oznacza, że palenie jest obojętne lub korzystne dla naszego organizmu.

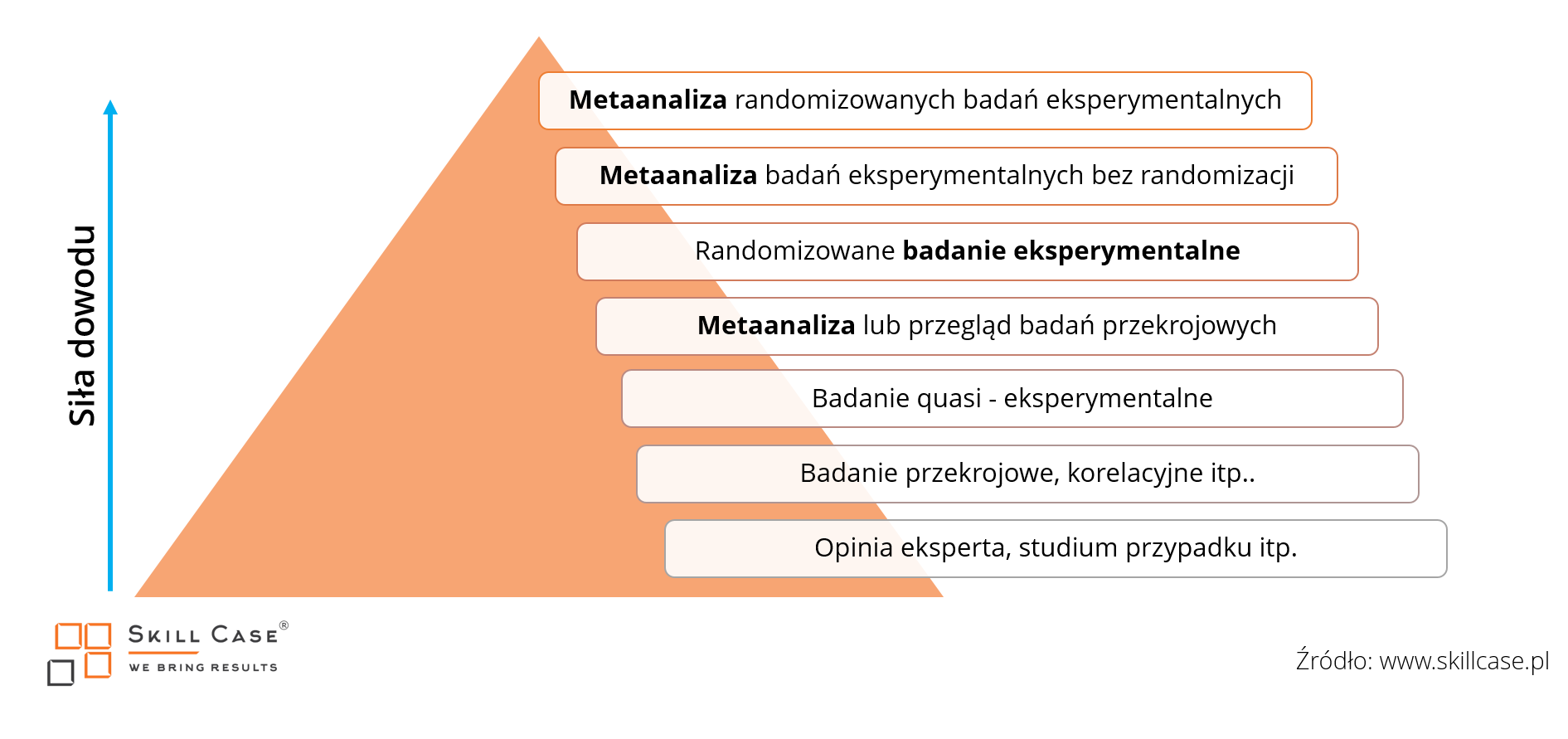

Badania naukowe z kolei (z eksperymentem na czele) prowadzone są zgodnie z rygorystyczną metodologią, a po opublikowaniu poddawane krytyce przez społeczność naukową. Dzięki temu szansa, że badanie zawiera błąd lub nieuprawniony wniosek spada. Żartobliwie proces publikacji artykułu naukowego można przedstawić tak: http://www.scienceandink.com/screen_res/nz060.jpg Dowody możemy podzielić na te silniejsze i te słabsze, przykładową hierarchię zawierającą wybrane typy dowodów zamieszczam poniżej.

Piramida dowodów

Pomiędzy metaanalizami i obserwacjami pojedynczych przypadków rozpościera się spektrum dowodów o różnej sile. Badania wykorzystujące współczynnik korelacji polegają na zestawieniu co najmniej dwóch zmiennych i określeniu, czy wzrost wartości jednej łączy się ze wzrostem wartości drugiej. Na przykład – sprawdzamy, czy Klienci, którzy kupili bochenek chleba kupili również pomidora. W odróżnieniu od eksperymentu badacz nie wpływa na wspomniane zjawiska a jedynie je obserwuje i mierzy.

Jeżeli dwa zjawiska współwystępują ze sobą w czasie/przestrzeni trudno powiedzieć, które zjawisko jest przyczyną, a które skutkiem. Być może oba zjawiska łączy trzeci czynnik, który jest przyczyną, a którego nie zauważyliśmy? Przykładowo – obserwujemy korelację pomiędzy liczbą wypitych kaw i czasem jaki pracownik spędza w pracy. Czy oznacza to, że wypijanie większej liczby kaw powoduje korzystanie z nadgodzin? A może Dłuższe pozostanie w pracy łączy się z częstszym piciem tego napoju? Niekoniecznie. Może istnieć trzeci czynnik – np. duża liczba zadań do realizacji, który jest przyczyną konieczności dłuższego przebywania w pracy i działania “na wyższych obrotach”, co może skłaniać do picia większej ilości kawy.

Niewłaściwe wnioski wyciągane ze współczynnika korelacji mogą być wyjątkowo zabawne – wiedząc, że istnieje związek pomiędzy liczbą pożarów a liczbą interwencji strażaków można by wyciągnąć błędny wniosek, że to wyjazd strażaków powoduje pożary. Badania quasi eksperymentalne charakteryzują się niepełnym zastosowaniem procedury eksperymentalnej. W quasi eksperymencie może zostać pominięty np. pre-test (pomiar przed próbą wpłynięcia na którąś ze zmiennych) lub procedura randomizacji (losowego przydzielenia do grup – eksperymentalnej lub kontrolnej). Taka forma badania pozwala sprawdzić czy działanie X powoduje rezultat Y (a nie na odwrót), jest jednak obciążona możliwością wyciągnięcia błędnych wniosków.

Przykładowo – badając skuteczność handlowców może się okazać, że do grupy eksperymentalnej, testującej nową metodę sprzedaży przydzieliliśmy samych asów, a w grupie kontrolnej (która stanowi punkt odniesienia, porównania) znaleźli się ci przeciętni. Jeżeli dodatkowo nie zmierzymy wyników sprzedażowych obu grup “na wejściu” – takie porównanie może dać nam fałszywie pozytywne informacje dotyczące skuteczności nowych praktyk sprzedażowych.

W końcu – ideał – badanie eksperymentalne. Dzięki niemu możliwe jest odkrywanie prawidłowości rządzących światem (i biznesem!). Polega na podjęciu próby wywołania zmiany w określonym obiekcie (grupie) i porównanie wyników tego oddziaływania z wariantem bez oddziaływania (tzw. próbą kontrolną). Wymaga takiego zaprojektowania sytuacji, żeby poza czynnikiem, którym manipulujemy nic innego nie wpływało na obiekt (grupę) w którym chcemy wywołać zmiany. Dokładnie opiszę możliwości zastosowania tej procedury w organizacji w kolejnym artykule dotyczącym gromadzenia danych płynących z organizacji.

Warto zauważyć, że bazowanie na informacjach o wysokim prawdopodobieństwie błędu zmniejsza szansę na podjęcie trafnej decyzji, nawet pomimo poprawnego procesu decyzyjnego. Obrazuje to znana informatykom zasada Garbage In, Garbage Out (GIGO), czyli „Śmieci Włożysz, Śmieci Wyjmiesz”. Zasada ta głosi, że korzystając z idealnie logicznych algorytmów obliczeniowych (decyzyjnych), ale podając błędne dane uzyskamy nieprawdziwy wynik. Jest więc zasadne, żeby w analizy biznesowe takie jak SWOT i cały proces podejmowania decyzji, włączać ocenę wartości dowodów, którymi dysponujemy.

...

Opieranie się na silnych danych zwiększa szansę podjęcia trafnej decyzji. Do oceny dowodów możemy użyć w uproszczeniu dwóch kryteriów – liczby zbadanych przypadków i liczby czynników, które mogły wpłynąć na wyciągnięcie fałszywych wniosków. Bazowanie na pojedynczych przypadkach i nieformalnych obserwacjach zwiększa ryzyko podjęcia błędnej decyzji, oparcie się na danych z wielu przypadków zgromadzonych w sposób kontrolowany – zmniejsza to ryzyko.